定制基于Qwen2.5-14B-Instruct专属AI票务助手

Qwen2.5-14B-Instruct是基于Qwen2.5架构优化的140亿参数指令微调模型。该模型采用先进的Transformer解码器架构,支持128K上下文长度,并集成了分组查询注意力(GQA)和滑动窗口注意力(SWA)机制,显著提升了长序列处理的效率和推理速度。Qwen2.5-14B-Instruct通过大规模多阶段指令微调,在对话交互、逻辑推理、代码编程及多语言任务中表现出卓越的遵循指令能力和响应质量。模型兼具高性能与部署灵活性,为需要高精度理解和复杂任务处理的AI应用提供了高效的解决方案。

在当前企业亟需AI应用具备领域专业知识与人性化交互体验的背景下,LLaMA-Factory凭借其零代码可视化微调框架,结合高质量领域数据集,可实现“分钟级”定制专属行业大模型。以打造智能票务客服场景为例,通过将Qwen2.5-14B-Instruct模型与航空客服数据深度融合,成功将通用大模型转化为具备航班查询、座位偏好识别、业务话术规范的“票务专家”。

配合LLaMA Factory Online平台提供的开箱即用数据集与弹性GPU算力,用户无需编码即可完成从数据上传、模型训练到交互测试的全流程闭环。该平台支持按需自定义创建GPU和CPU实例,用户可一键启动符合业务需求的计算资源。其高性能GPU算力满足高精度推理与训练需求,同时提供 “JupyterLab” 和 “VS Code” 等开发环境,便于利用CPU实例进行数据预处理与模型调试,有效提升大模型应用开发效率。

这种“框架+平台+场景”的融合方案,显著降低了领域大模型的定制门槛,为智能客服、角色对话、专业咨询等企业级应用提供了高效可行的轻量化落地路径。

前提条件

- 用户已经获取LLaMA Factory Online平台账户和密码,如果需要帮助或尚未注册,可参考注册账户完成注册。

- 当前账号的余额充裕,可满足实例运行的需要。点击可了解最新的活动及费用信息,或前往充值,如需了解更多请联系我们。

- 下载Cherry Studio客户端工具,客户端下载可参考客户端章节所述,添加自定义服务商请参考自定义服务商对应章节所述。

操作步骤

配置概览

| 配置参数 | 配置项 | 说明 |

|---|---|---|

| 模型 | Qwen2.5-14B-Instruct | Qwen2.5-14B-Instruct是一款高效的140亿参数模型,支持128K长上下文,专为高效推理与编程而生。 |

| 数据集 | weclone_air_dialogue-sft | 英文航空订票客服场景对话数据集,其中assistant角色是航空公司订票客服,会对user的问询提供专业的订票服务。 |

| GPU | H800*4(推荐) | - |

| 微调方法 | lora | - |

操作详情

-

使用已注册的LLaMA Factory Online账号登录平台,选择[实例空间]菜单项,进入实例空间页面,例如下图所示。

-

单击上图“开始微调”按钮,进入[配置资源]页面,选择GPU资源,卡数填写

4,其他参数保持为默认值,单击“启动”按钮,启动实例。

-

单击“启动”按钮,待实例启动后,点击[LLaMA-Factory快速微调模型]页签,进入LLaMA Factory Online在线WebUI微调配置页面,语言选择

zh,如下图高亮①所示;模型名称选择Qwen2.5-14B-Instruct,如下图高亮②所示;系统默认填充模型路径/shared-only/models/Qwen/Qwen2.5-14B-Instruct,如下图高亮③所示。 -

微调方法选择

lora,如下图高亮④所示;选择“train”标签,训练方式保持Supervised Fine-Tuning,如下图高亮⑤所示;数据路径保持/workspace/llamafactory/data,如下图高亮⑥所示;数据集选择平台内置的weclone_air_dialogue-sft,如下图高亮⑦所示。 -

(可选)其余参数可根据实际需求调整,具体说明可参考参数说明,本实践中的其他参数设置如上图橙色框所示。

-

参数配置完成后,点击“开始”按钮启动微调任务。页面底部将实时显示微调过程中的日志信息,例如下图高亮①所示;同时展示当前微调进度及Loss变化曲线。经过多轮微调后,例如下图高亮②所示,从图中可以看出Loss逐渐趋于收敛。微调完成后,系统提示“训练完毕”,例如下图高亮③所示。

模型对话

- 微调后模型对话

- 原生模型对话

-

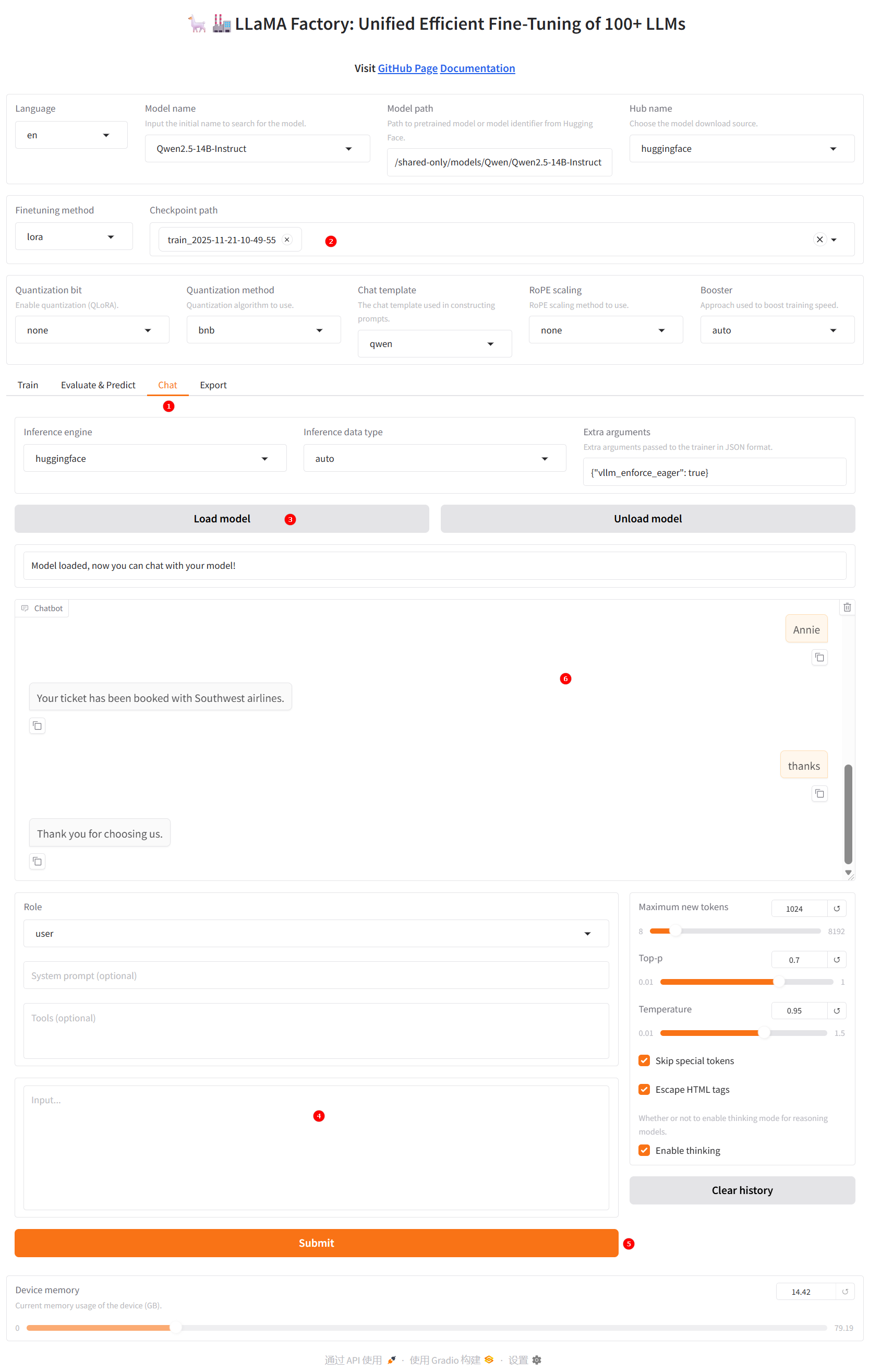

切换至“chat”界面,如下图高亮①所示;选择上一步骤已经训练完成的检查点路径,如下图高亮②所示;单击“加载模型”按钮,如下图高亮③所示;微调的模型加载后,在输入框处填入提问(高亮④),点击“提交”(高亮⑤);在下图高亮⑥观察模型回答。

维度 模型微调后回答 模型微调后回答 核心功能 专注于高效、准确地完成从搜索、选择、填料到支付出票的完整交易闭环。 致力于理解用户自然语言表达的真实意图,并提供灵活、个性化的行程建议。 交互模式 线性、分步式流程。系统主导,用户按既定步骤输入信息,路径清晰,确定性高。 用户主导,需提出新需求或变更需求,路径较为发散。 准确性 ✅ 极高。能精准识别明确指令,如正确解析“DFW-IAD”航线并显示真实航班数据。 ❌ 不稳定。将“IAD”误识别为“LAX”,暴露出在地名消歧、上下文理解方面的重大缺陷。 完成度 ✅ 完整闭环。流程终点是机票成功预订,生成票号,达成核心商业目标。 ❌ 中断或偏离。因识别错误,对话陷入“需求澄清”循环,无法推进至实际预订阶段。 用户体验 高效、可控、可预测,给目标明确的用户带来安全感和信任感。 关键错误会严重挫败用户,损害其对系统能力的信任。

-

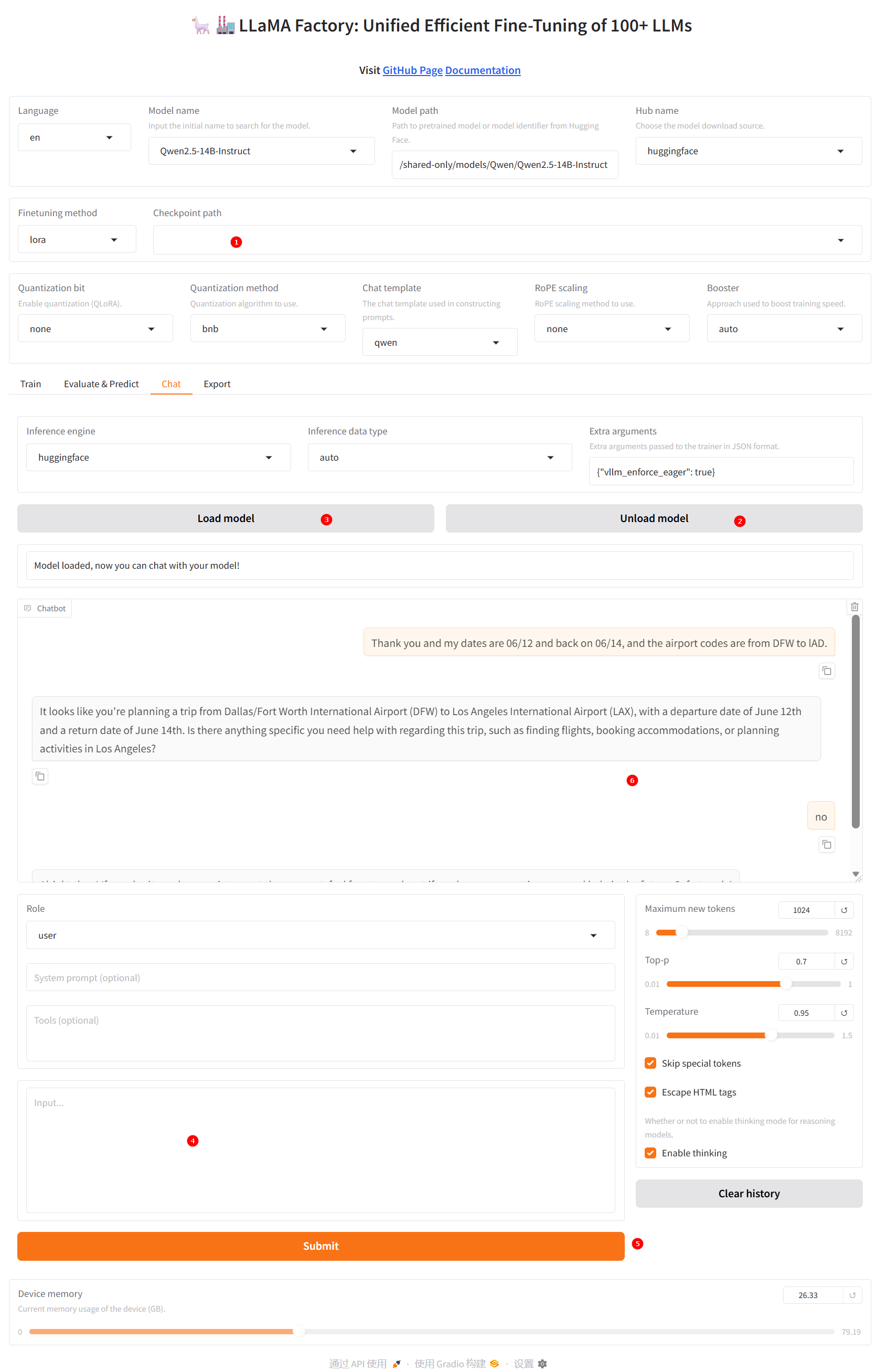

清空“检查点路径”中的LoRA配置(高亮①),单击下图高亮②所示的“卸载模型”按钮,卸载微调后的模型,模型卸载完成后,单击“加载模型”按钮(下图高亮③所示),加载原生的

Qwen3-8B-Base模型进行对话,其余配置保持不变。在输入框处填入提问(高亮④),点击“提交”(高亮⑤);在下图高亮⑥观察模型回答。

微调后的模型在任务执行能力上实现了显著提升,能够精准响应用户需求,构建了从查询到订票的清晰、闭环操作流程。作为一款垂直领域的工具型助手,该模型专注于高效完成特定任务,以准确性与可靠性为核心优势,确保用户需求得到直接、有效的满足。

在交互过程中,模型不仅能准确识别用户对航班时刻、起降地点等关键信息的查询,还能生成贴合实际业务场景的回复,并主动引导用户完成订票操作。在多轮对话中,模型展现出优秀的上下文理解与连贯性,彻底摆脱了以往仅提供建议性回复的局限,在专业度与实用性上实现了质的飞跃,真正成为可投入实际业务的高效智能助手。

总结

综上所述,Qwen2.5-14B-Instruct 的真正优势在于其在通用大模型基础上与航空客服数据的深度融合,成功实现了从“通用智能”到“领域专家”的跃迁。通过精细微调与行业知识注入,该模型不仅精准掌握航班动态查询、舱位余量分析、退改签规则等核心票务能力,更能智能识别旅客的座位偏好、出行习惯与情绪诉求,输出符合民航服务规范的专业话术。作为一位全天候在线的“智能票务专家”,Qwen2.5-14B-Instruct 不仅显著提升了客服响应效率与服务一致性,更在人机交互中构建起专业、温暖、可信赖的服务体验,让航空出行服务更智能、更人性化。