构建基于Llama-3.2-11B-Vision-Instruct金融分析

在金融领域中,图表承担了展示信息的重要责任,而读取图表中所包含的信息对每位金融从业者更是必不可少的机能。如今,金融分析愈发成熟,我们每天需要处理的图标也随之越来越复杂,此时AI的引入能够帮助我们更有效更快速地抓取关键信息在金融领域中,图表承担了展示信息的重要责任,而读取图表中所包含的信息对每位金融从业者更是必不可少的机能。如今,金融分析愈发成熟,我们每天需要处理的图表也随之越来越复杂,此时AI的引入能够帮助我们更有效更快速地抓取关键信息。

金融特化版Llama-3.2-11B-Vision-Instruct是针对金融分析与决策优化的多模态模型,能够同时处理文本、数据和视觉输入(如财报、市场指标、K线图等),输出包括财务分析、风险提示、趋势解读等结构化洞察。其应用涵盖自动化投研(快速提取关键财务信号)、合规审查(识别文档风险点)及可视化报告生成(结合图表与文本分析),通过金融领域语料和视觉数据的针对性微调,提升了处理复杂金融信息的准确性与实用性,适用于投行、资管和企业财务等场景。

前提条件

- 用户已经获取LLaMA-Factory Online平台账户和密码,如果需要帮助或尚未注册,可参考注册账户完成注册。

- 当前账号的余额充裕,可满足模型微调服务的需要。点击可了解最新的活动及费用信息,或前往充值,如需了解更多请联系我们。

操作步骤

配置概览

| 配置参数 | 配置项 | 是否预置 | 说明 |

|---|---|---|---|

| 模型 | Llama3.2-11B-Vision-Instruct | 是 | 经过指令微调,参数量约110亿 (11B),专为处理图像和文本数据的任务而设计。 |

| 数据集 | fin_mme | 是 | 金融多模态推理评估基准数据集。 |

| GPU | H800*4(推荐) | - | H800**2(最少)。 |

| 微调方法 | lora | - | 显著降低计算与存储成本,兼具高性能与部署灵活性。 |

资源消耗预览

- 模型微调时长

- 微调后模型Evaluate & Predict时长

- 原生模型Evaluate & Predict时长

操作详情

-

使用已注册的LLaMA Factory Online账号登录平台,选择[实例空间]菜单项,进入实例空间页面,例如下图所示。

-

单击上图“开始微调”按钮,进入[配置资源]页面,选择GPU资源,卡数填写

4,其他参数保持为默认值,例如下图所示。

-

单击“启动”按钮,待实例启动后,点击[LLaMA-Factory快速微调模型]页签,进入LLaMA-Factory Online在线WebUI微调配置页面,语言选择

zh,如下图高亮①所示;模型名称选择Llama-3.2-11B-Vision-Instruct,如下图高亮②所示;系统默认填充模型路径/shared-only/models/meta-llama/Llama-3.2-11B-Vision-Instruct。 -

微调方法选择

lora,如下图高亮④所示;选择“train”功能性,训练方式保持Supervised Fine-Tuning,如下图高亮⑤所示;数据路径保持/workspace/llamafactory/data,如下图高亮⑥所示;数据集选择平台已预置的fin_mme,如下图高亮⑦所示。

点击“设置/常规”,即可获取API Key,示例如下图所示。 SwanLab是一款开源且轻量级的AI模型训练可视化追踪工具。在本次微调任务中,我们将使用SwanLab记录整个微调过程。在开始之前,请确保您已经登录SwanLab平台。登录后,点击“设置/常规”,即可获取API Key,示例如下图所示。

-

(可选)其余参数可根据实际需求调整,具体说明可参考参数说明,本实践中的其他参数均保持默认值。

-

参数配置完成后,点击“开始”按钮启动微调任务。页面底部将实时显示微调过程中的日志信息,例如下图高亮①所示;同时展示当前微调进度及Loss变化曲线。经过多轮微调后,例如下图高亮②所示,从图中可以看出Loss逐渐趋于收敛。微调完成后,系统提示“训练完毕”,例如下图高亮③所示。

- 微调后模型对话

- 原生模型对话

-

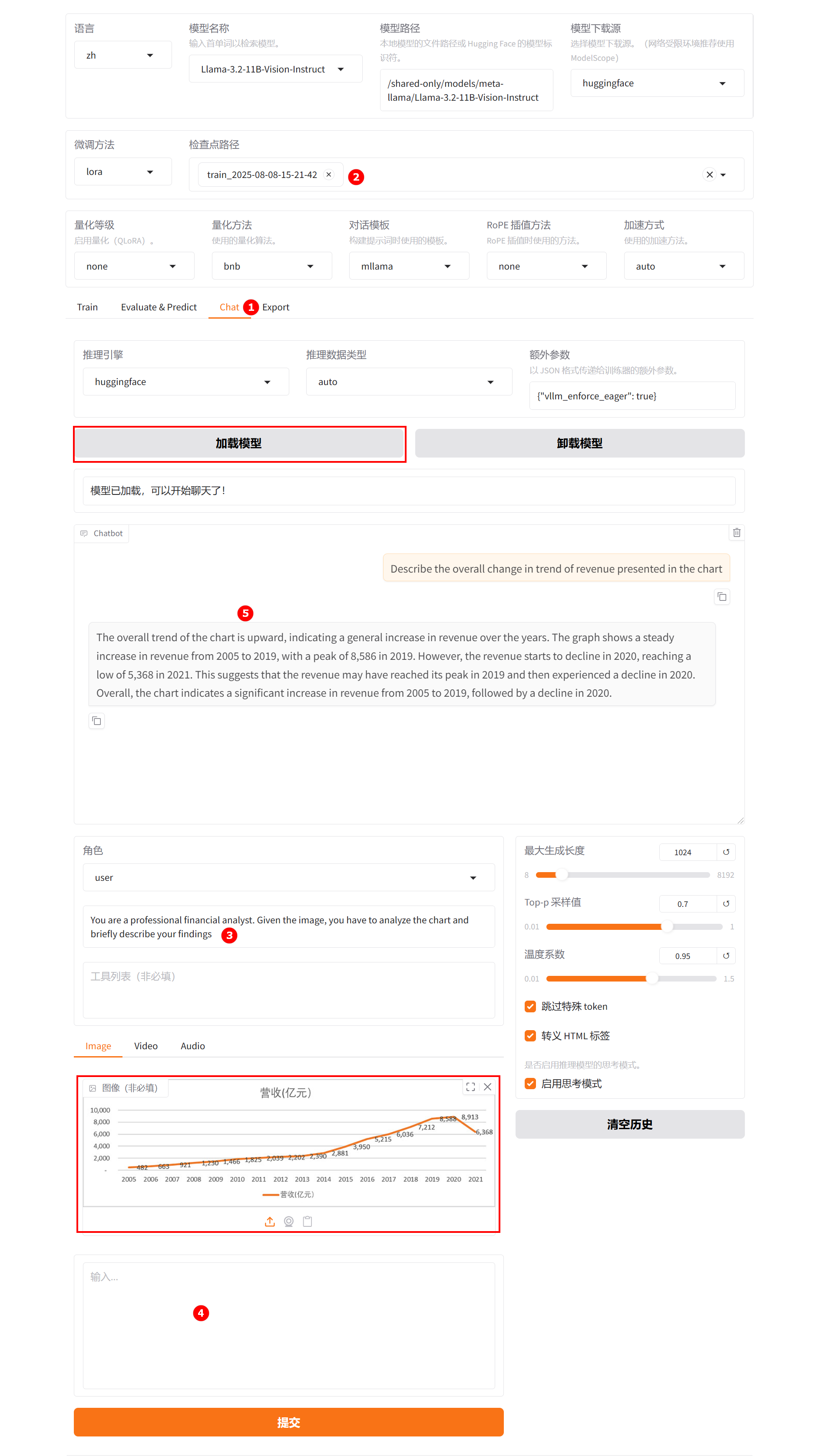

切换至“chat”界面,如下图高亮①所示;选择上一步骤已经训练完成的检查点路径,如下图高亮②所示;单击“加载模型”按钮,微调的模型加载后,在系统提示词处填入提示词,如下图高亮③所示;上传图片后输入用户模拟词“Describe the overall change in trend of revenue presented in the chart”,观察模型回答,如下图高亮⑤所示。

-

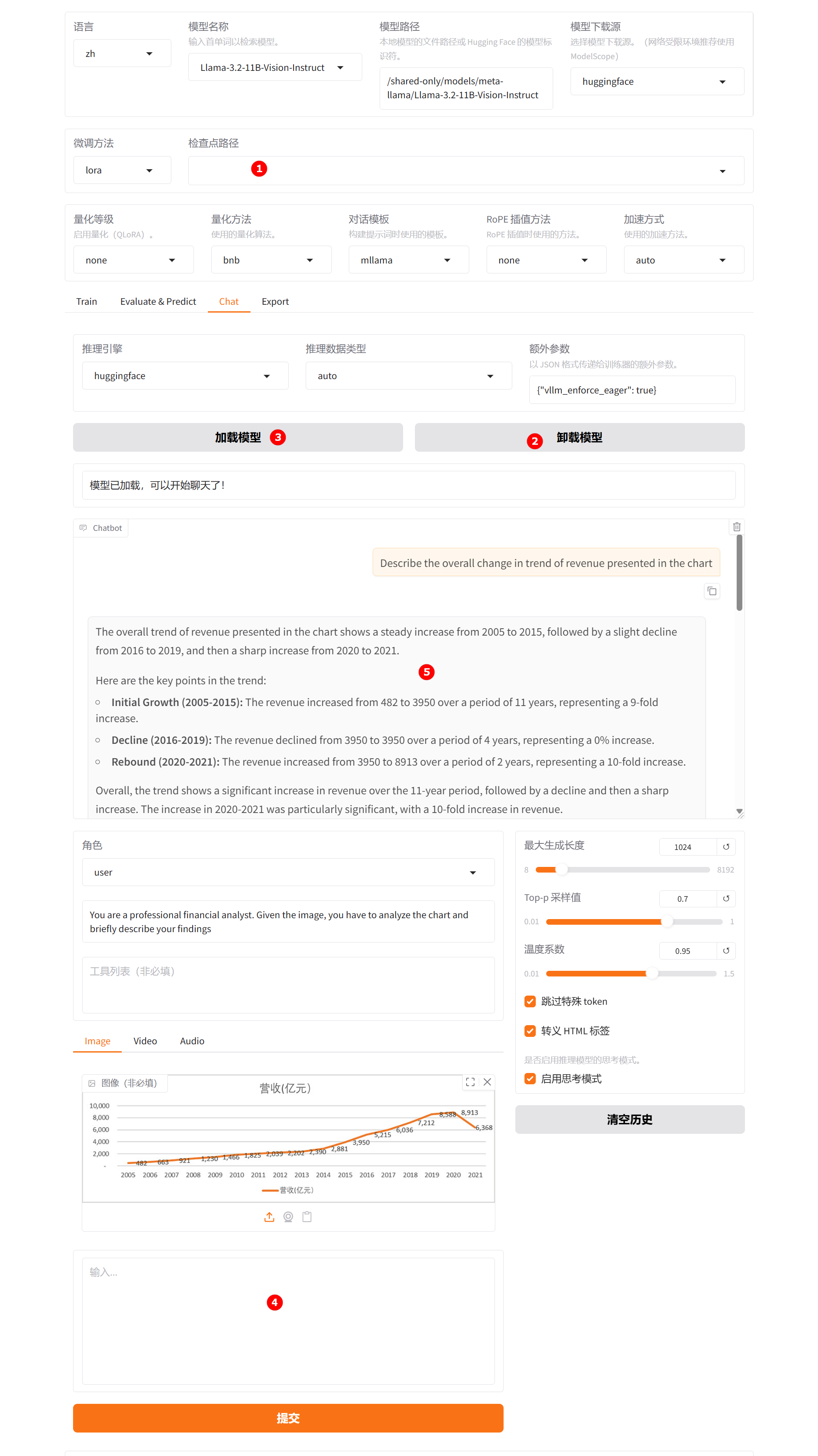

清空“检查点路径”中的LoRA配置,单击下图高亮②所示的“卸载模型”按钮,卸载微调后的模型,模型卸载完成后,单击“加载模型”按钮,加载原生的

Llama-3.2-11B-Vision-Instruct模型进行对话,其余配置保持不变。用户模拟词依旧输入“Describe the overall change in trend of revenue presented in the chart”,观察模型回答,如下图高亮⑤所示。

通过对比微调模型与原生模型的输出结果可以发现,微调后的模型在图表读取上表现出更强的契合度,其回答不仅更贴近系统预设的角色定位,也更符合用户的认知预期。

- 微调后模型评估

- 原生模型评估

-

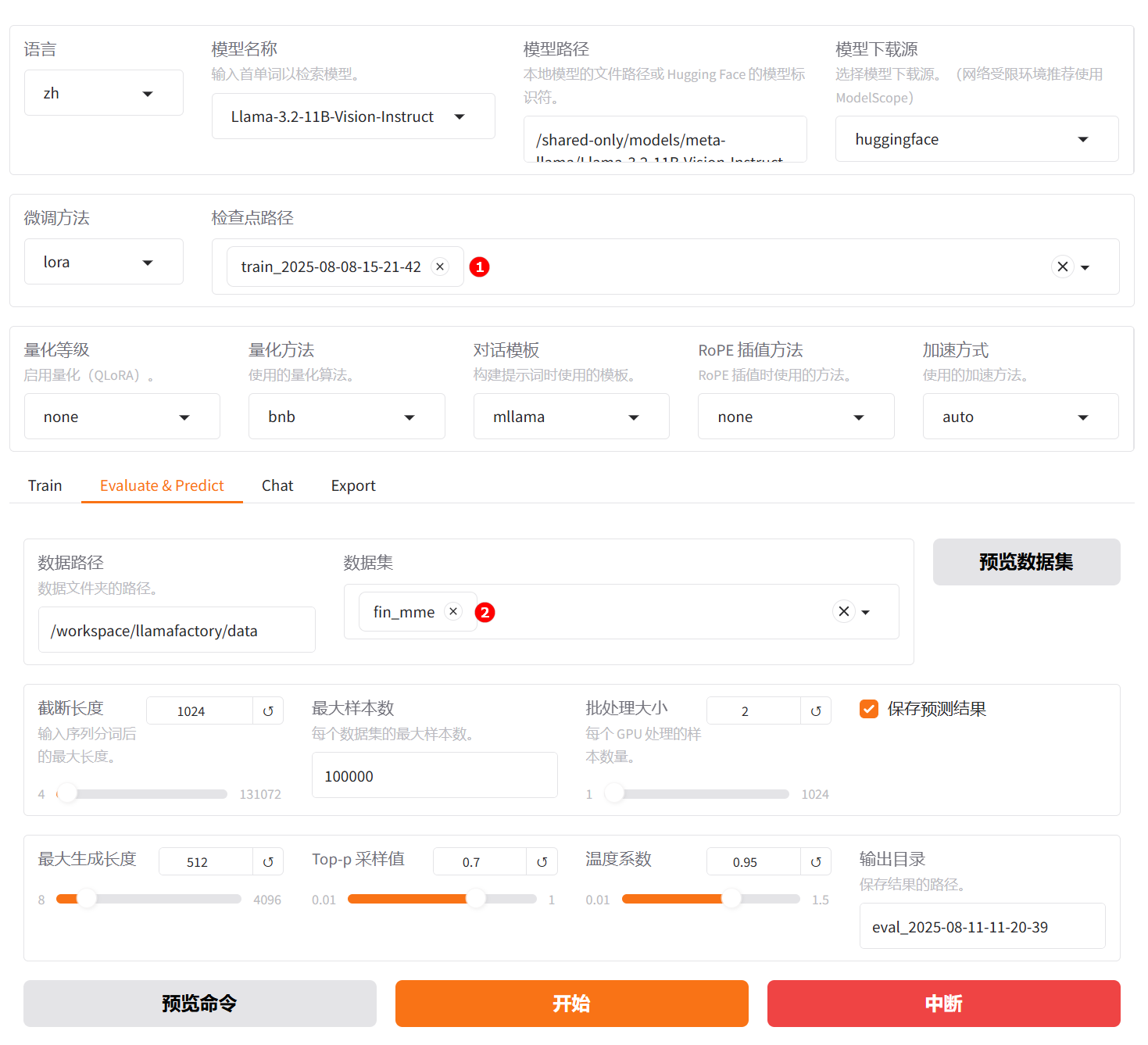

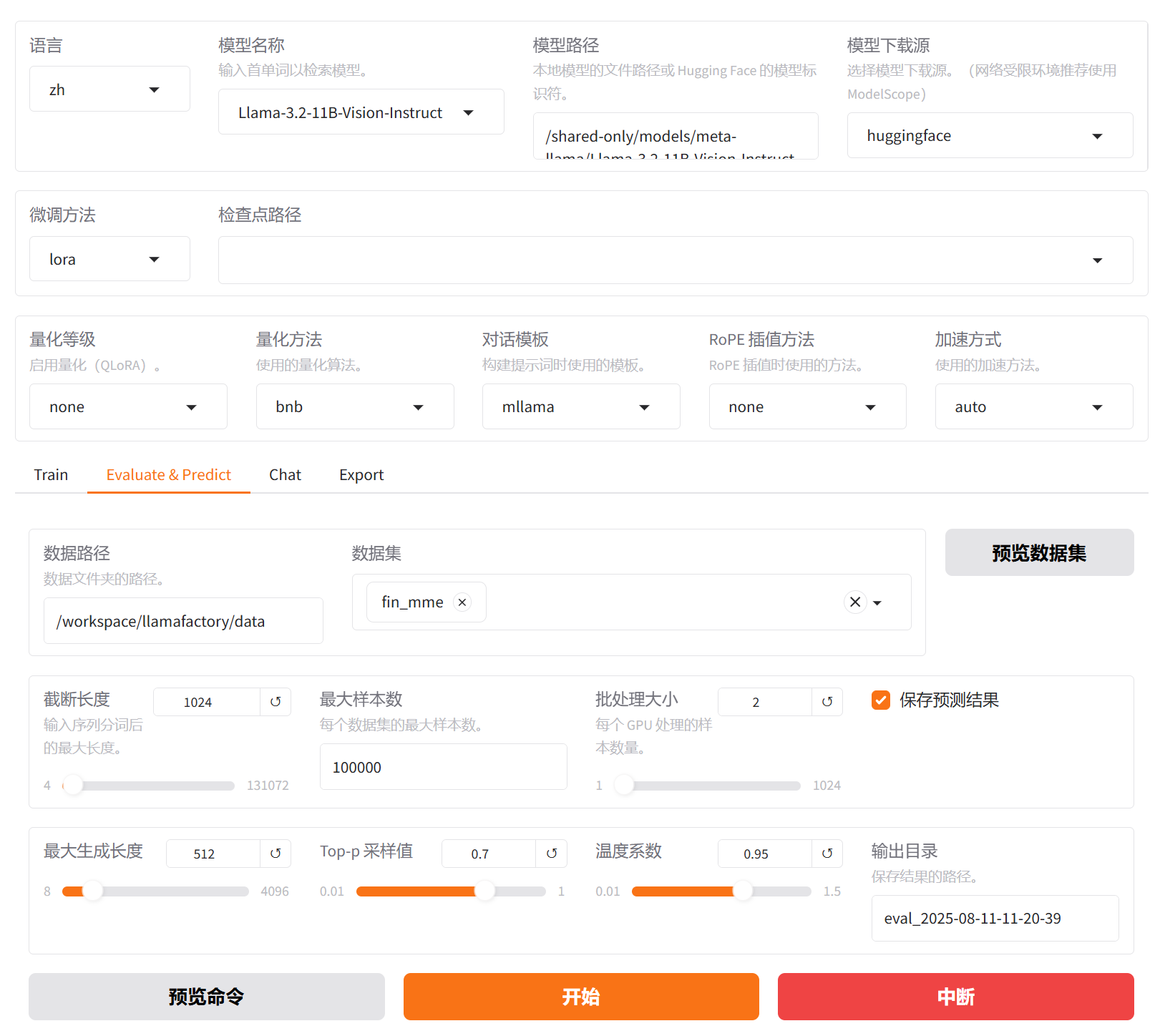

切换至“Evaluate & Predict”页面,选择微调后模型的检查点路径,例如下图高亮①所示;然后选择平台预置的

fin_mme数据集,并根据实际需求配置评估参数(本实践的参数设置如下图所示)。

-

参数配置完成后,点击“开始”按钮即可启动评估,页面底部将实时显示评估过程中的日志信息,评估完成后,记录评估结果,结果如下所示。

{

"predict_bleu-4": 27.38479177927928,

"predict_model_preparation_time": 0.0082,

"predict_rouge-1": 46.59722225225225,

"predict_rouge-2": 0.07882882882882883,

"predict_rouge-l": 46.59722225225225,

"predict_runtime": 475.4967,

"predict_samples_per_second": 18.673,

"predict_steps_per_second": 2.334

}结果解读:该模型在语义覆盖(

ROUGE-1)、句法连贯性(ROUGE-L)和短语匹配(ROUGE-2)方面均有良好表现,相较原生模型评估BLEU-4=6.66,有了明显改进,该版本已具备使用基础。

-

切换至“Evaluate & Predict”页面,清空检查点路径配置,数据集依旧选择平台预置的

fin_mme数据集,并根据实际需求配置评估参数(本实践的参数设置如下图所示)。

-

完成配置后,点击“开始”按钮即可启动评估,页面底部将实时显示评估过程中的日志信息,评估完成后,记录评估结果,结果如下所示。

{

"predict_bleu-4": 6.658312105855856,

"predict_model_preparation_time": 0.0082,

"predict_rouge-1": 16.22191519144144,

"predict_rouge-2": 0.0002194144144144144,

"predict_rouge-l": 15.523695371621622,

"predict_runtime": 12083.6165,

"predict_samples_per_second": 0.735,

"predict_steps_per_second": 0.092

}结果解读:评价指标(

BLEU-4、ROUGE-1/2/L)均处于较低水平,尤其是BLEU-4和ROUGE-2,表明模型生成内容与参考答案在词汇、短语和句子结构层面匹配度较差。当前模型的评估得分整体偏低,尤其在语言流畅性与结构准确性方面表现较弱,生成质量有进一步提升。

对比微调后模型评估与原生模型评估结果可以看出,二者在生成质量方面存在显著差异。原生模型表现较差,不仅生成质量相关指标全面偏低(BLEU-4: 6.66,ROUGE-1: 16.22,ROUGE-2:0.0002,ROUGE-L:15.52),其在生成内容与参考答案在词汇、短语及句子结构层面匹配度低,语言连贯性和语义准确性不足。而微调后模型在相同评估条件下有明显提升,生成质量上,BLEU-4:27.38,ROUGE-1:46.60,ROUGE-2和ROUGE-L也分别达到0.0079和46.60,显示出更优的关键词覆盖能力、短语搭配合理性和句级语义连贯性。表明微调后的模型显著增强了语言生成质量。综上,微调后的模型生成性能上远优于原生模型,具备更好的应用潜力。

总结

用户可通过LLaMA-Factory Online平台预置的模型及数据集完成快速微调与效果验证。从上述实践案例可以看出,基于Llama3.2-11B-Vision-Instruct模型,采用LoRA方法在fin_mme金融数据集上进行指令微调后,模型在处理文本、数据和视觉输入(如财报、市场指标、K线图等),输出包括财务分析、风险提示、趋势解读等结构化洞察等方面均有显著提升。

本实践构建自动化投研、合规审查、可视化报告生成系统提供了可复用的技术路径,适用于投行、资管和企业财务等场景。未来可进一步探索多模态输入输出、强化实时数据联动能力、优化长周期时序分析能力,构建行业细分场景的适配性,增强模型的可解释性和可追溯性。