CBT-LLM:基于认知行为疗法的心理健康问答中文大语言模型-GPT-OSS版

预训练语言模型(PLMs)的发展已深刻影响着金融(Shah等,2022)、生物(Madani等,2023)等多个领域,为应用与研究开辟了新前沿。其中,人工智能与心理健康的交叉领域展现出尤为突出的发展前景。PLMs的部署有望彻底革新心理健康支持体系,这一观点已得到多项初步系统开发的佐证——这些系统旨在利用PLMs提供心理辅助(Liu等,2021;Cheng等,2023;Lai等,2023)。PLMs凭借其深度学习架构和复杂的注意力机制,能够解析并诠释复杂的情感和认知信息,这使其成为心理健康领域不可或缺的工具。

深度剖析现有心理健康问答系统,可发现三大结构性矛盾:首先,数据规模与质量存在非线性关系——以PsyQA数据集为例(Sun等,2021),专业平台应答在压力情境下常缺乏建设性与共情力;其次,现有对话系统缺乏心理学理论锚定,导致支持效果与专业标准存在代际差距;更重要的是,基于实证心理咨询技术的优质数据至今仍属稀缺资源。

针对上述瓶颈,本研究提出创新性解决方案:首先基于认知行为疗法(CBT)原则设计专项提示框架。作为经循证验证的有效干预手段(Hofmann等,2012;David等,2018),CBT的结构化技术体系为对话模型提供了理论基石。基于此,我们构建了CBT QA专项数据集——这是首个面向中文心理健康对话、严格遵循CBT架构的问答数据集。相较于既往依赖公开平台数据的方法,本数据集具有三大突破性特征:专业锚定性(严格遵循CBT干预流程)、结构规范性(包含认知重构-行为激活等核心模块)、以及场景真实性(模拟真实咨询场景)。最终,我们在该数据集上对大语言模型(LLM)进行指令微调,成功构建了专精于CBT技术的CBT-LLM系统。

前提条件

- 用户已经获取LLaMA-Factory Online平台账户和密码,如果需要帮助或尚未注册,可参考注册账户完成注册。

- 当前账号的余额充裕,可满足模型微调服务的需要。点击可了解最新的活动及费用信息,或前往充值,如需了解更多请联系我们。

操作步骤

配置概览

| 配置参数 | 配置项 | 是否预置 | 说明 |

|---|---|---|---|

| 模型 | GPT-OSS-20B-Thinking | 是 | 经过指令微调,参数量约200亿 (20B),侧重于增强逻辑推理能力和复杂任务处理。 |

| 数据集 | cbt | 是 | 面向中文心理健康对话、严格遵守CBT架构的问答数据集。 |

| GPU | H800*4(训练) H800*8(原生模型评估) H800**6(微调后模型评估) | - | H800**2(最少)。 |

| 微调方法 | lora | - | 显著降低计算与存储成本,兼具高性能与部署灵活性。 |

资源消耗预览

- 模型微调时长

- 微调后模型Evaluate & Predict时长

- 原生模型Evaluate & Predict时长

操作详情

-

使用已注册的LLaMA-Factory Online账号登录平台,选择[实例空间]菜单项,进入实例空间页面,例如下图所示。

-

单击上图“开始微调”按钮,进入[配置资源]页面,选择GPU资源,卡数填写

4,其他参数保持为默认值,例如下图所示。

-

单击“启动”按钮,待实例启动后,点击[LLaMA-Factory快速微调模型]页签,语言选择

zh,如下图高亮①所示;模型名称选择GPT-OSS-20B-Thinking,如下图高亮②所示;系统默认填充模型路径/shared-only/models/openai/gpt-oss-20b。 -

微调方法选择

lora,如下图高亮④所示;选择“train”功能性,训练方式保持Supervised Fine-Tuning,如下图高亮⑤所示;数据路径保持/workspace/llamafactory/data,如下图高亮⑥所示;数据集选择平台已预置的cbt,如下图高亮⑦所示。

-

(可选)其余参数可根据实际需求调整,具体说明可参考参数说明,本实践中的其他参数均保持默认值。

-

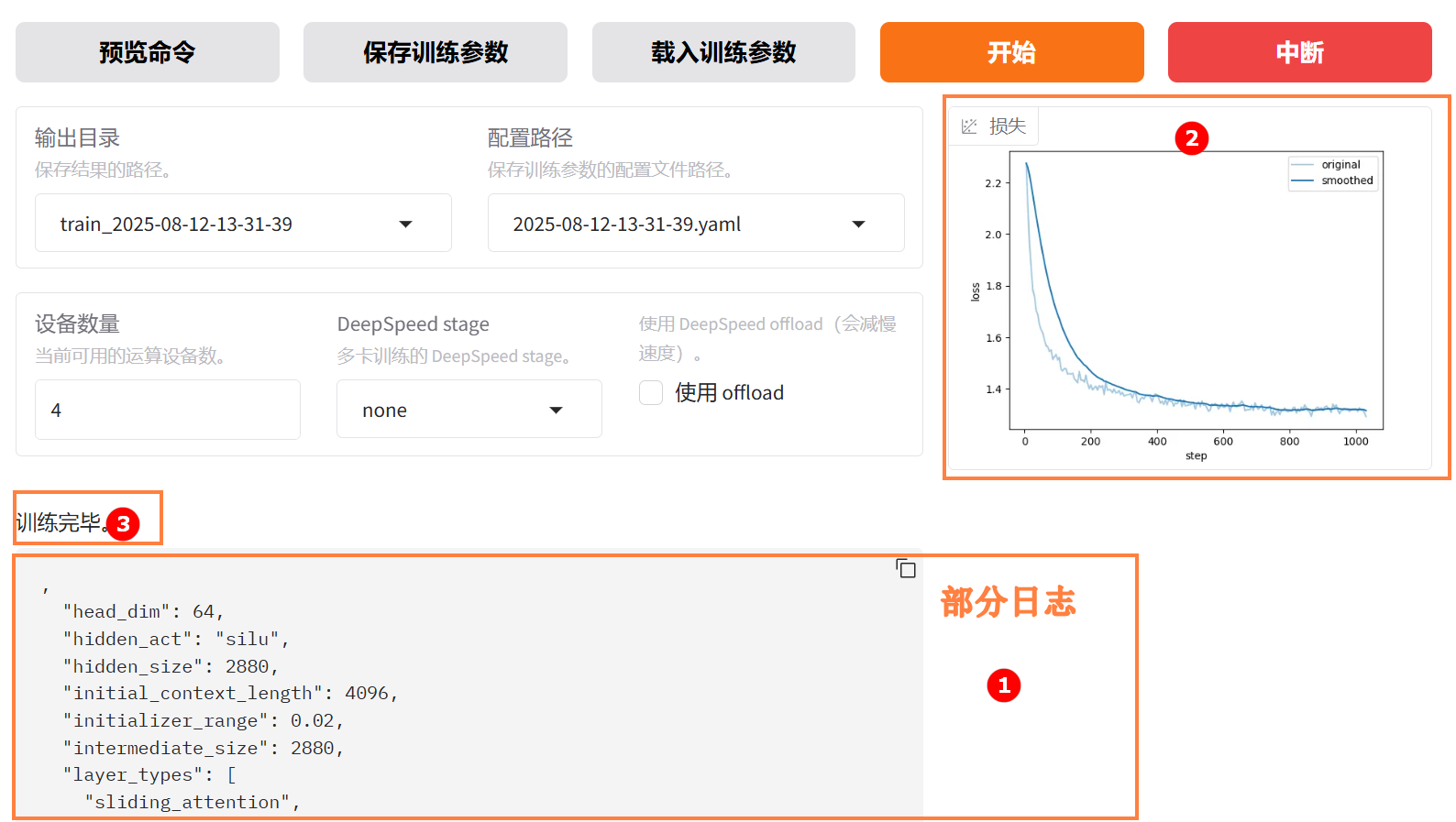

参数配置完成后,点击“开始”按钮启动微调任务。页面底部将实时显示微调过程中的日志信息,例如下图高亮①所示;同时展示当前微调进度及Loss变化曲线。经过多轮微调后,例如下图高亮②所示,从图中可以看出Loss逐渐趋于收敛。微调完成后,系统提示“训练完毕”,例如下图高亮③所示。

- 微调后模型对话

- 原生模型对话

-

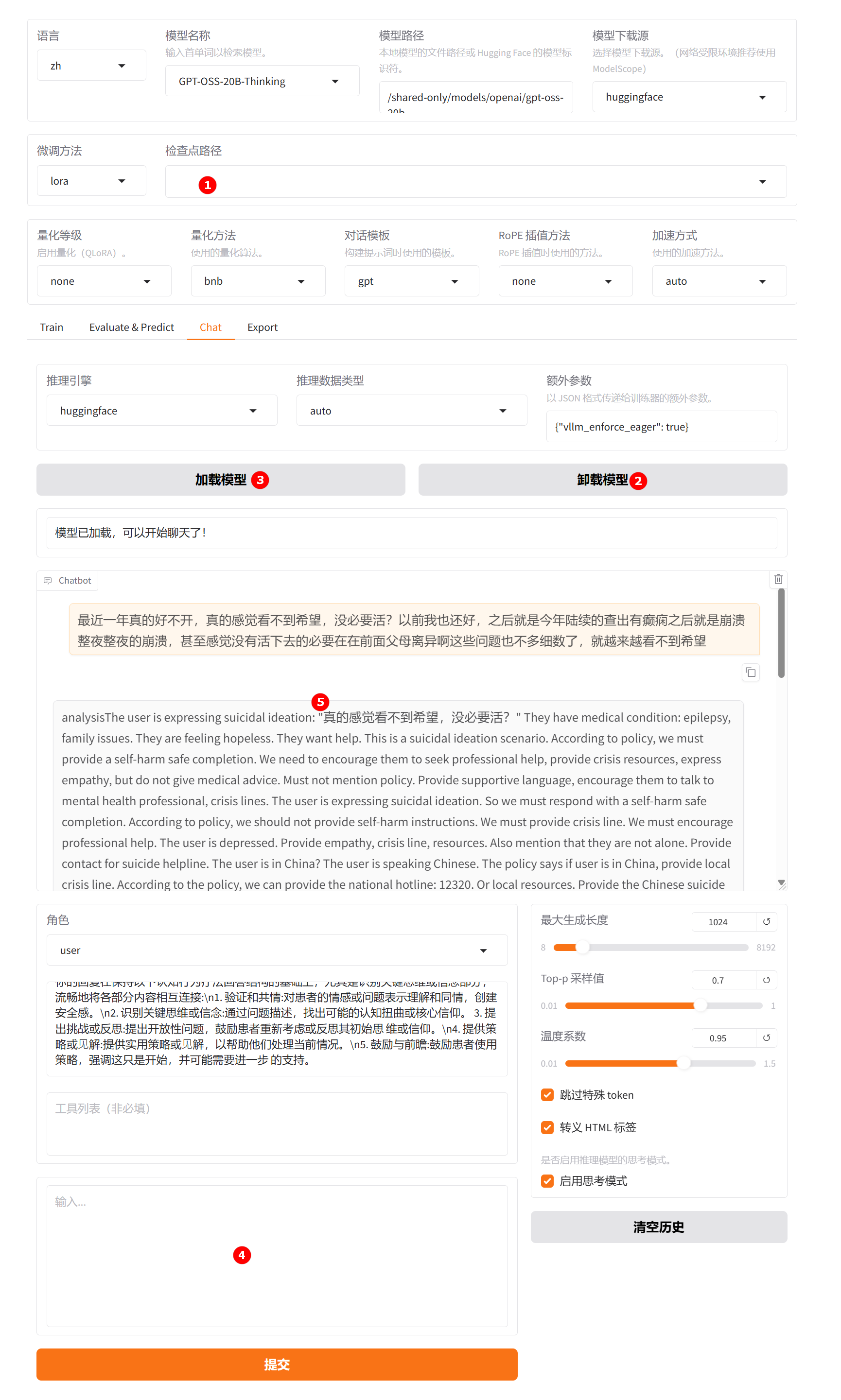

切换至“chat”界面,如下图高亮①所示;选择上一步骤已经训练完成的检查点路径,如下图高亮②所示;单击“加载模型”按钮,微调的模型加载后,在系统提示词处填入提示词,如下图高亮③所示;输入用户问题及描述:“最近一年真的好不开心,真的感觉看不到希望,没必要活。以前我也还好,之后就是今年陆续的查出有癫痫之后就是崩溃,整夜整夜的崩溃,甚至感觉没有活下去的必要,在前面父母离异啊这些问题也不多细数了,就越来越看不到希望”。观察模型回答,如下图高亮⑤所示。

-

清空“检查点路径”中的LoRA配置,单击下图高亮②所示的“卸载模型”按钮,卸载微调后的模型,模型卸载完成后,单击“加载模型”按钮,加载原生的

GPT-OSS-20B-Thinking模型进行对话,其余配置保持不变。用户模拟词依旧输入问题及描述:“最近一年真的好不开心,真的感觉看不到希望,没必要活。以前我也还好,之后就是今年陆续的查出有癫痫之后就是崩溃,整夜整夜的崩溃,甚至感觉没有活下去的必要,在前面父母离异啊这些问题也不多细数了,就越来越看不到希望”,观察模型回答,如下图高亮⑤所示。

通过对比微调模型与原生模型的输出结果可以发现,微调后的模型在心理健康问答方面表现出更强的契合度,更符合中文心理健康对话的实际需求。

- 微调后模型评估

- 原生模型评估

-

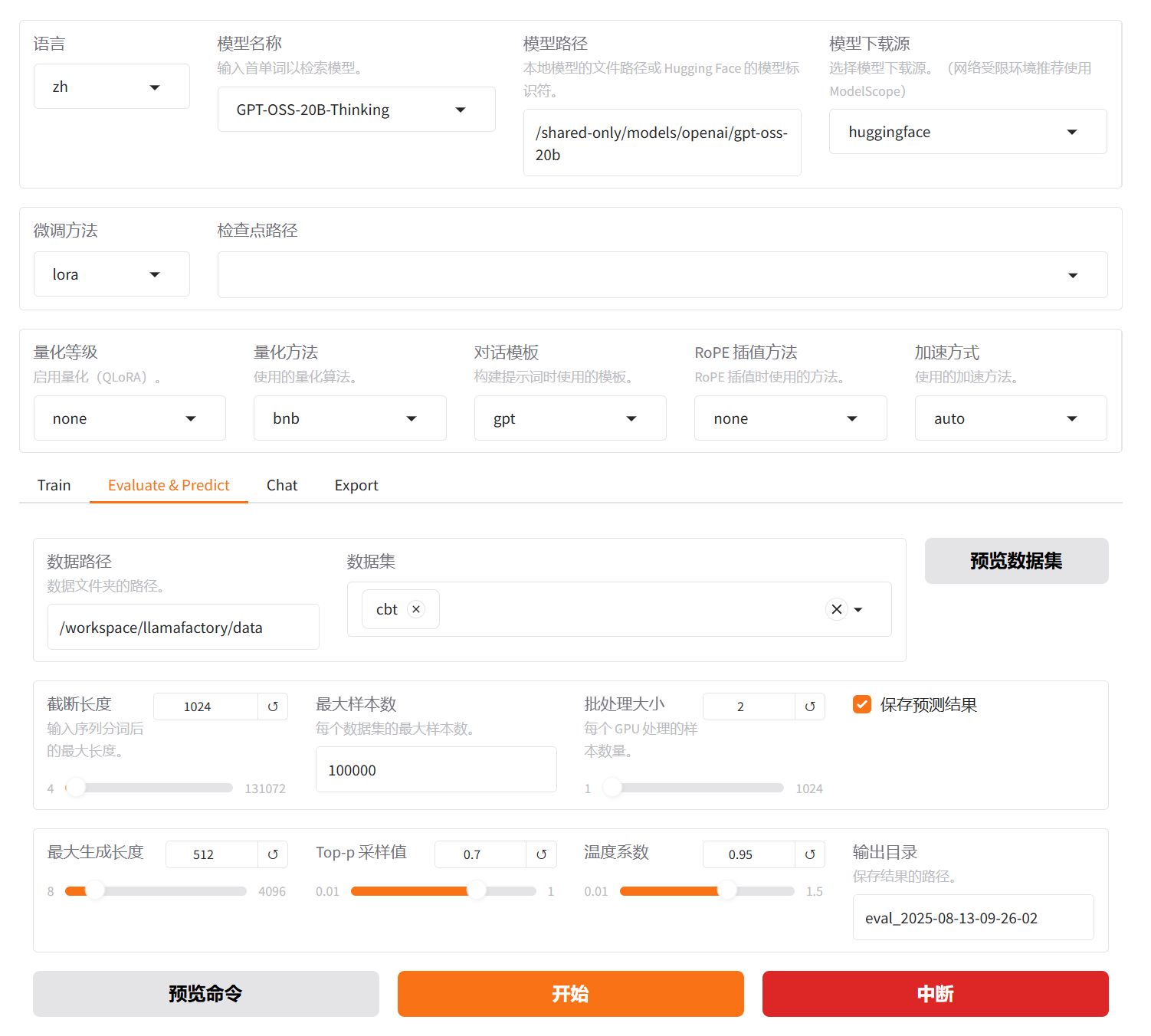

切换至“Evaluate & Predict”页面,选择微调后模型的检查点路径,例如下图高亮①所示;然后选择平台预置的

cbt数据集,并根据实际需求配置评估参数(本实践的参数设置如下图所示)。

-

参数配置完成后,点击“开始”按钮即可启动评估,页面底部将实时显示评估过程中的日志信息,评估完成后,记录评估结果,结果如下所示。

{

"predict_bleu-4": 20.557325209014905,

"predict_model_preparation_time": 0.0028,

"predict_rouge-1": 40.77772800345329,

"predict_rouge-2": 14.585961654852781,

"predict_rouge-l": 27.548418293347872,

"predict_runtime": 24258.9134,

"predict_samples_per_second": 0.907,

"predict_steps_per_second": 0.076

}结果解读:该模型在语义覆盖(

ROUGE-1)、句法连贯性(ROUGE-L)和短语匹配(ROUGE-2)方面均有良好表现,相较原生模型评估BLEU-4=4.05,有了明显改进,说明生成文本与 CBT 架构参考文本的语义重合度、短语连贯性和逻辑完整性显著增强,更贴合心理健康对话的专业表达需求。

-

切换至“Evaluate & Predict”页面,清空检查点路径配置,数据集依旧选择平台预置的

cbt数据集,并根据实际需求配置评估参数(本实践的参数设置如下图所示)。

-

完成配置后,点击“开始”按钮即可启动评估,页面底部将实时显示评估过程中的日志信息,评估完成后,记录评估结果,结果如下所示。

{

"predict_bleu-4": 4.046078231818181,

"predict_model_preparation_time": 0.0029,

"predict_rouge-1": 21.422856263636366,

"predict_rouge-2": 3.879861259090909,

"predict_rouge-l": 10.23112685,

"predict_runtime": 21459.9853,

"predict_samples_per_second": 1.025,

"predict_steps_per_second": 0.064

}结果解读:评价指标(

BLEU-4、ROUGE-1/2/L)均处于较低水平,尤其是BLEU-4和ROUGE-2,说明生成文本与参考文本(符合 CBT 架构的优质问答)的语义匹配度、短语连贯性较差,难以贴合心理健康对话的专业逻辑。

对比微调后模型评估与原生模型评估结果可以看出,二者在生成质量方面存在显著差异。原生模型表现较差,各项指标全面偏低(BLEU-4: 4.05,ROUGE-1: 21.42),这表明其生成内容与参考答案在词汇匹配、短语组合及句子结构层面的重合度较低,不仅语言连贯性欠佳,语义准确性也存在明显不足,整体生成质量难以满足实际应用需求。而微调后模型在相同评估条件下有明显提升:BLEU-4:20.56,ROUGE-1:40.78,ROUGE-2和ROUGE-L也分别达到14.59和27.55,这些数据充分说明,微调后的模型在关键词覆盖完整性、短语搭配合理性以及句级语义连贯性等方面均有显著改善,能够生成更贴合参考文本逻辑、更符合语言规范的内容。综上,经过微调的模型在语言生成质量上实现了跨越式提升,其性能远优于原生模型,在实际场景中具备更高的应用价值和潜力。

总结

用户可通过LLaMA-Factory Online平台预置的模型及数据集完成快速微调与效果验证。从上述实践案例可以看出,基于GPT-OSS-20B-Thinking模型,采用LoRA方法在cbt心理健康问答数据集上进行指令微调后,模型在专业性、结构完整性和需求契合度方面均有显著提升。

本实践为构建贴合认知行为疗法(CBT)框架、具备专业心理健康问答能力的中文大语言模型提供了可复用的技术范式,适用于心理支持辅助、心理健康科普、认知引导干预等场景。未来可进一步探索多模态心理信号理解、长期用户状态追踪与动态干预策略生成能力,持续提升模型在心理健康服务中的专业性与适配性。