悬浮操作框

VSCode和JupyterLab提供悬浮操作框,支持一键切换编辑器、关机、重置资产、对外服务等功能。

前提条件

- 您已经获取LLaMA-Factory Online账户和密码,如果需要帮助或尚未注册,可参考注册账户完成注册。

- 当前账号的余额充裕,可满足模型微调服务的需要。点击可了解最新的活动及费用信息,或前往充值,如需了解更多请联系我们。

概览

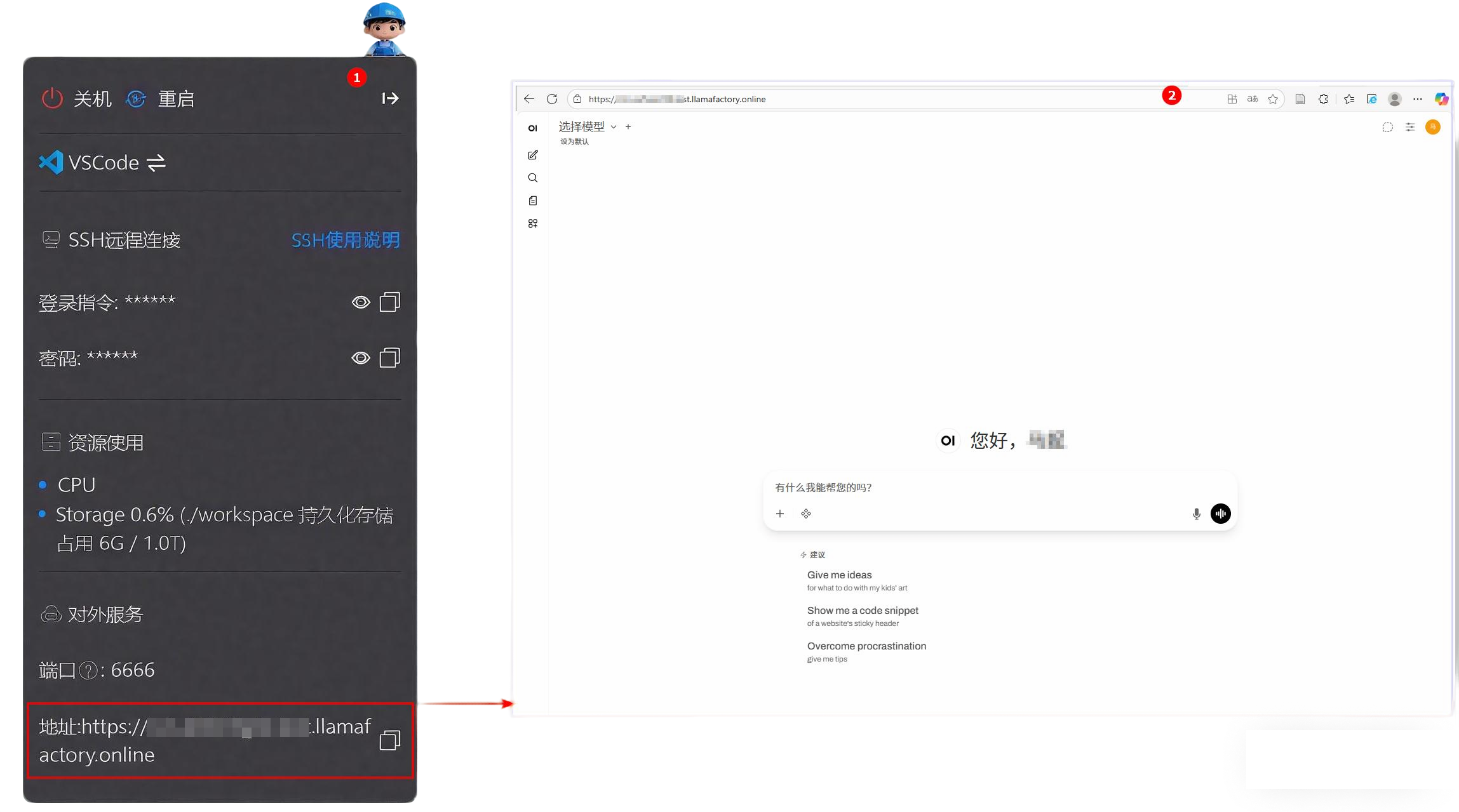

在实例空间页面,点击“开始微调”后,进入中间的“VSCode处理专属数据”,或者右侧的“JupyterLab处理专属数据”,都能在页面上看到悬浮操作框。如下图所示,具体功能见下表。

| 序号 | 功能名称 | 详细说明 |

|---|---|---|

| 1 | 悬浮操作框移动 | 点击后可将悬浮操作框拖动至屏幕任意位置,便于调整界面布局。 |

| 2 | 开发环境切换 | 点击可在VSCode与JupyterLab两种环境之间快速切换,满足不同编程与调试需求。 |

| 3 | SSH远程连接 | 点击可查看SSH连接方式的详细指引,帮助用户快速完成远程连接设置。 |

| 4 | 对外服务 | 启用后支持外部网络访问当前实例,方便进行服务部署、接口测试或协同开发。 |

| 5 | 关机/停止实例 | 安全关闭当前运行实例,释放资源,停止计费。请注意保存工作进度后再操作。 |

| 6 | 资源使用情况 | 实时显示当前实例所使用的计算资源类型(如 CPU/GPU)及使用数量,便于监控运行状态。 |

| 7 | 存储空间状态 | 显示实例存储空间的已用与剩余容量,帮助用户管理文件和数据存储。 |

| 8 | 重新配置资源 | 点击可重新选择或调整实例的计算资源、镜像环境等配置,适用于不同任务需求。 |

操作步骤

对外服务支持用户从外部访问实例空间内的自定义服务。下面以外部服务访问Open-webui为例,在VScode页面中的展示该功能操作步骤。(Jupyter Lab中的操作步骤与在VScode中一致。)

-

在实例空间页面,点击“开始微调”后,进行资源配置,选择GPU 1卡。

点击中间的“VSCode处理专属数据”进入VScode页面。点击左上角“Terminal”新建终端。 -

创建一个新的conda环境。(新环境名称为:open-webui,python版本为:3.11)

conda create -n open-webui python=3.11 -y -

激活环境。

conda activate open-webui -

安装open-webui。

pip install open-webui itsdangerous -i https://pypi.tuna.tsinghua.edu.cn/simple/ -

启动open-webui。启动速度较慢,请耐心等待。

open-webui serve --host 0.0.0.0 --port 6666 -

启动成功后,点击悬浮操作框的“对外服务按钮”,复制地址。新开一个浏览器网页,将地址复制到地址框,实现外部访问open-webui。可注册用户名和密码后登录。

提示

提示环境中还未下载模型,无法进行模型对话。

-

(可选)使用open-webui进行模型对话。

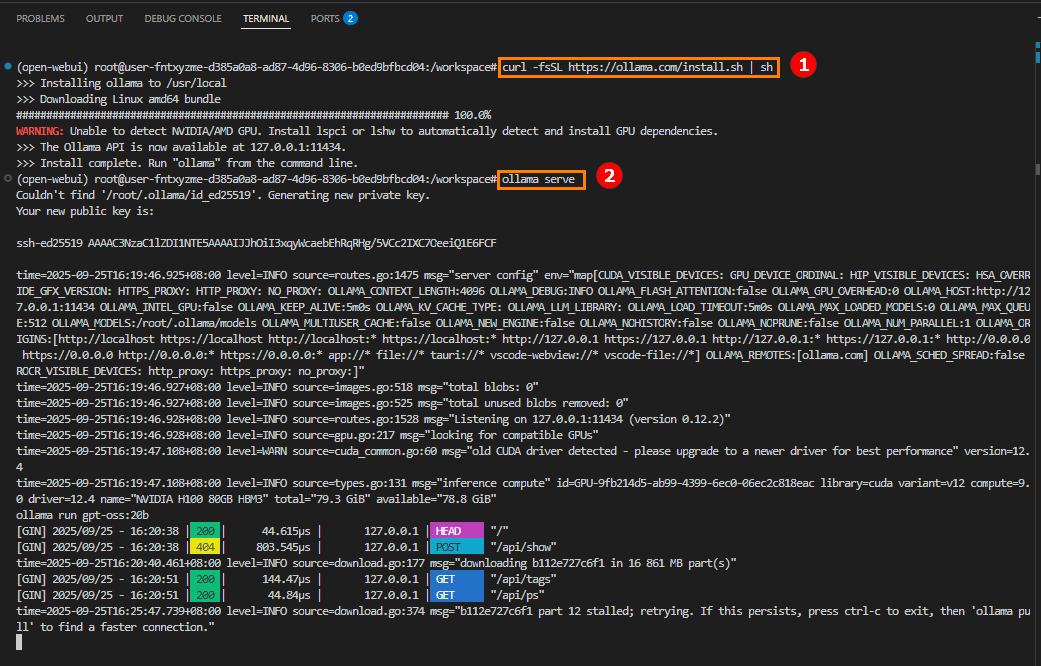

- 下载Ollama。 回到vscode页面,按“ctrl+c”退出步骤5的命令。输入以下命令,下载Ollama。

curl -fsSL https://ollama.com/install.sh | sh - 启动Ollama服务。

ollama serve

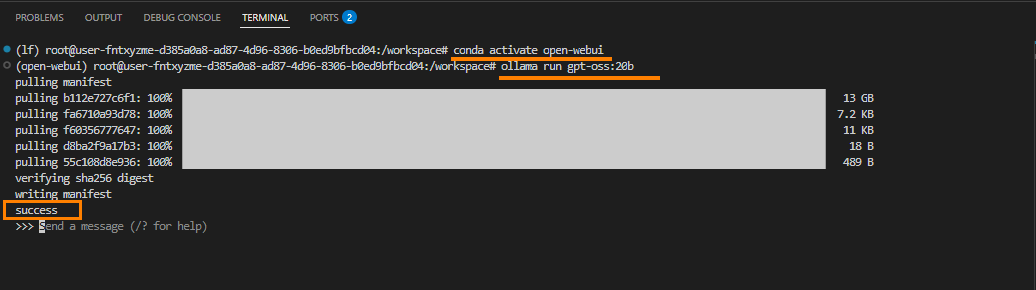

- 新建一个终端,进入open-webui环境,启动模型(以gpt-oss-20b为例)。

conda activate open-webuiollama run gpt-oss:20b

- 再新建一个终端,进入open-webui环境,启动open-webUI。

conda activate open-webuiopen-webui serve --host 0.0.0.0 --port 6666 - 启动成功后,点击悬浮操作框的“对外服务按钮”,复制地址。新开一个浏览器网页,将地址复制到地址框,实现外部访问open-webui。使用步骤6中注册的用户名和密码登录账户。在页面左上角选择模型:gpt-oss-20b,开始对话。

- 下载Ollama。 回到vscode页面,按“ctrl+c”退出步骤5的命令。输入以下命令,下载Ollama。