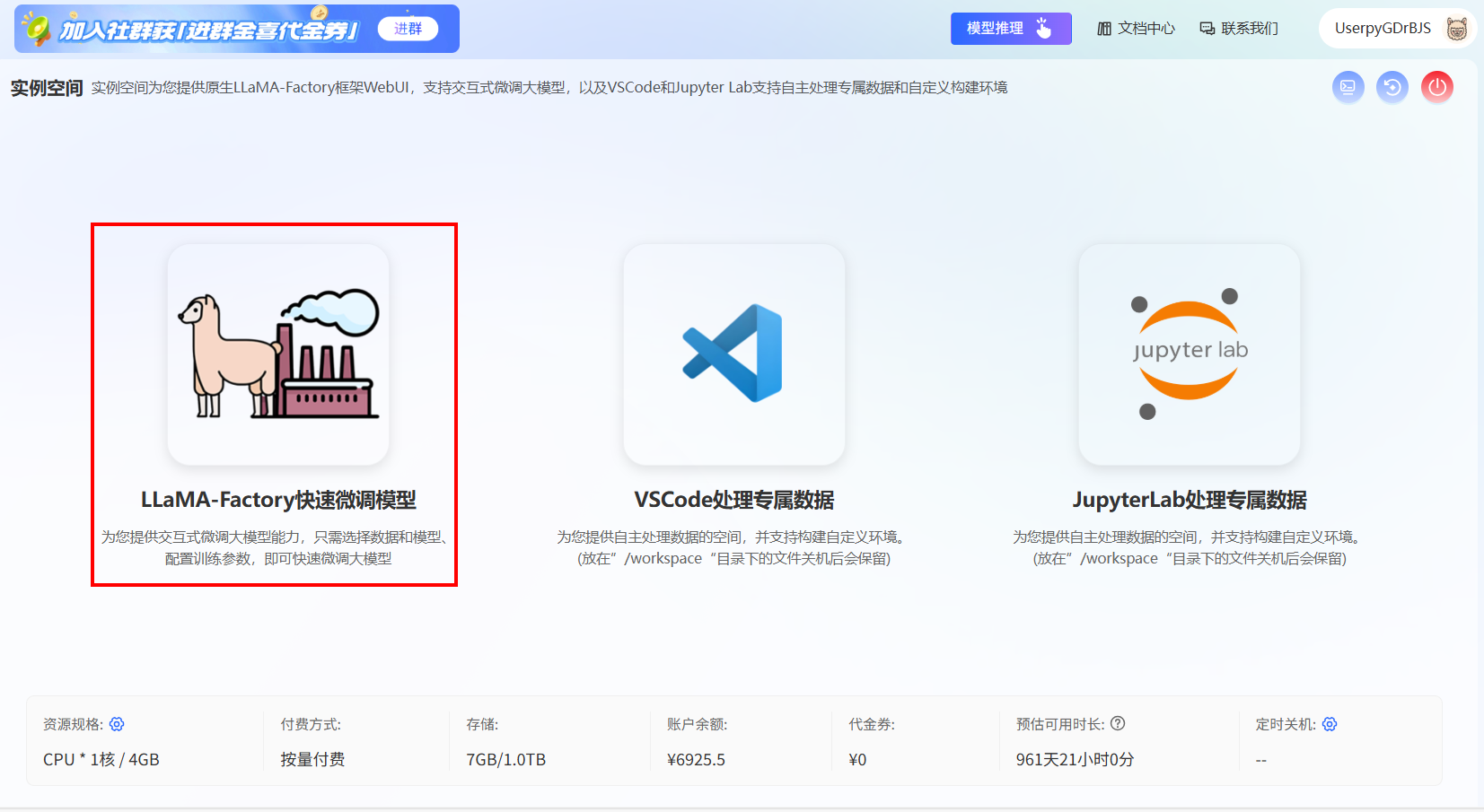

LLaMA-Factory快速微调模型

“LLaMA-Factory快速微调模型”为您提供原生LLaMA-Factory框架WebUI,支持交互式微调大模型能力,您只需选择数据和模型、配置训练参数,即可快速微调模型。

前提条件

- 您已经获取LLaMA-Factory Online账户和密码,如果需要帮助或尚未注册,可参考注册账户完成注册。

- 当前账号的余额充裕,可满足模型微调服务的需要。点击可了解最新的活动及费用信息,或前往充值,如需了解更多请联系我们。

- 您已经准备好符合格式的数据集和模型,您可使用平台内置的模型和数据集,或使用自定义模型或数据集。如需使用自定义模型,可参考模型上传导入模型,如需使用自定义数据集,可参考数据处理部分完成数据集的上传和处理。

概览

进入实例空间,点击“开始微调”选择合适的配置,启动实例后,点击进入“LLaMA-Factory快速微调模型”。

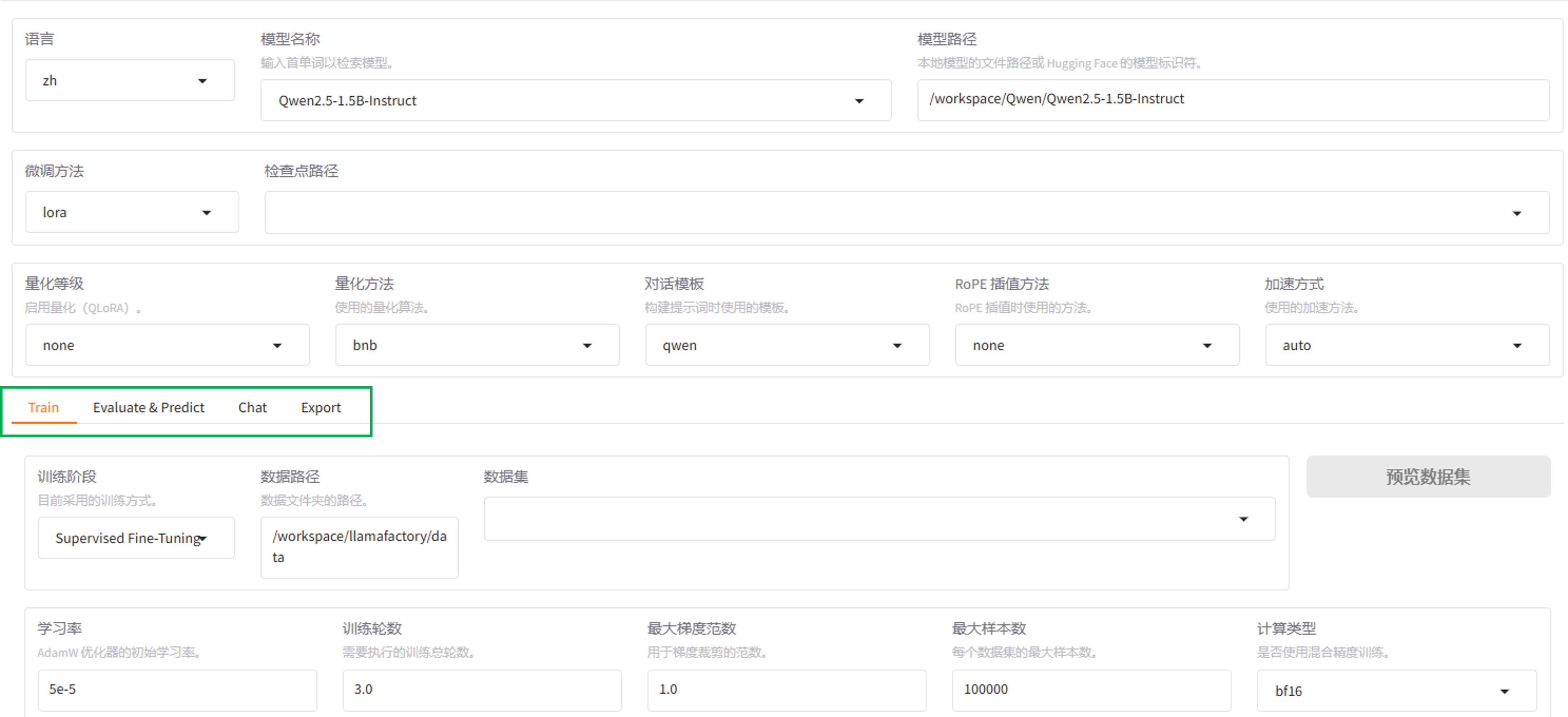

在模型微调页面,可根据需求进行模型微调,展开“训练”-“评估预测”-“推理聊天”-“导出模型”。

操作步骤

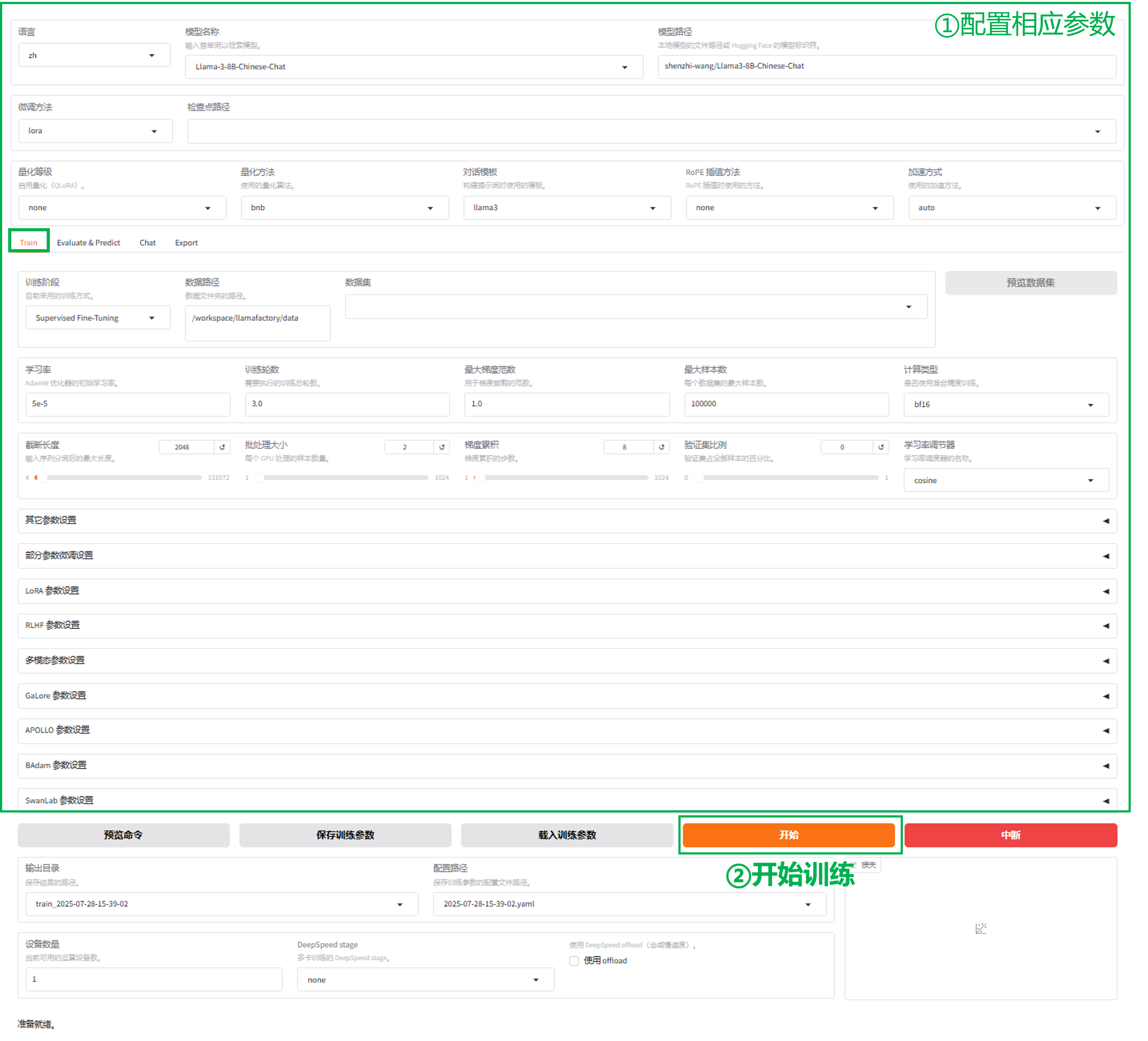

训练

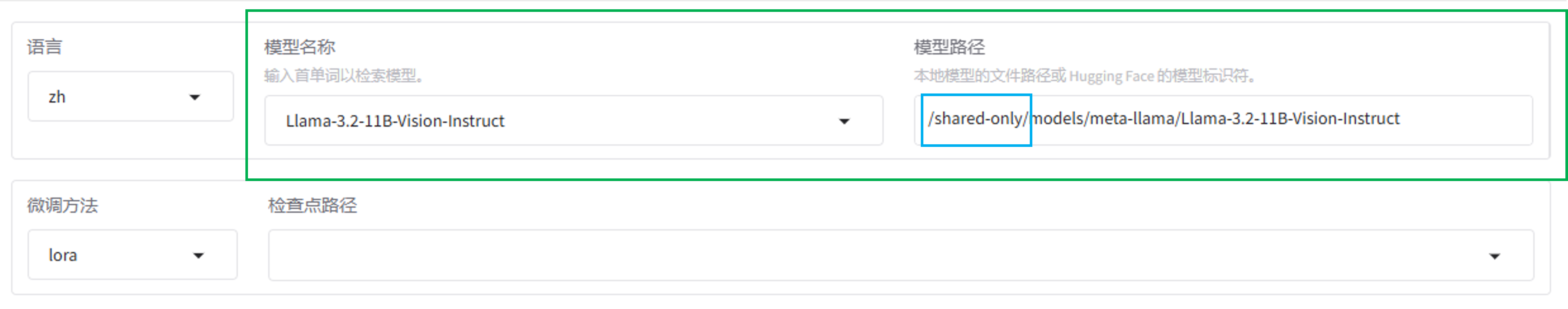

1.选择模型

-

选择预置模型。预置模型存放在路径

/share-only/models下,您可以直接在“模型名称”处选择需要的模型,“模型路径”处会自动同步更新。

-

选择自定义的模型。模型路径

/share-only/models下没有的模型,需要用户自行下载。

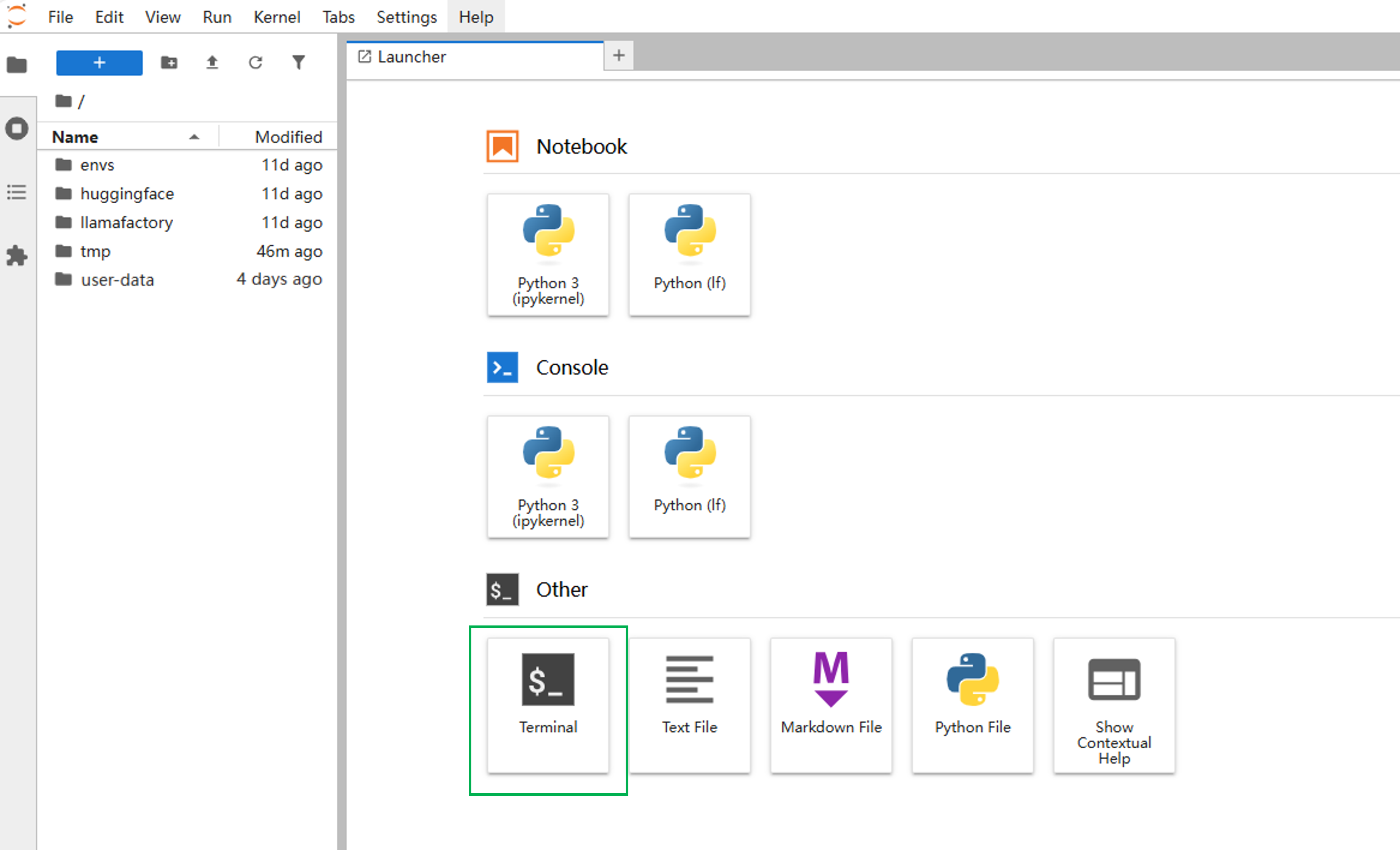

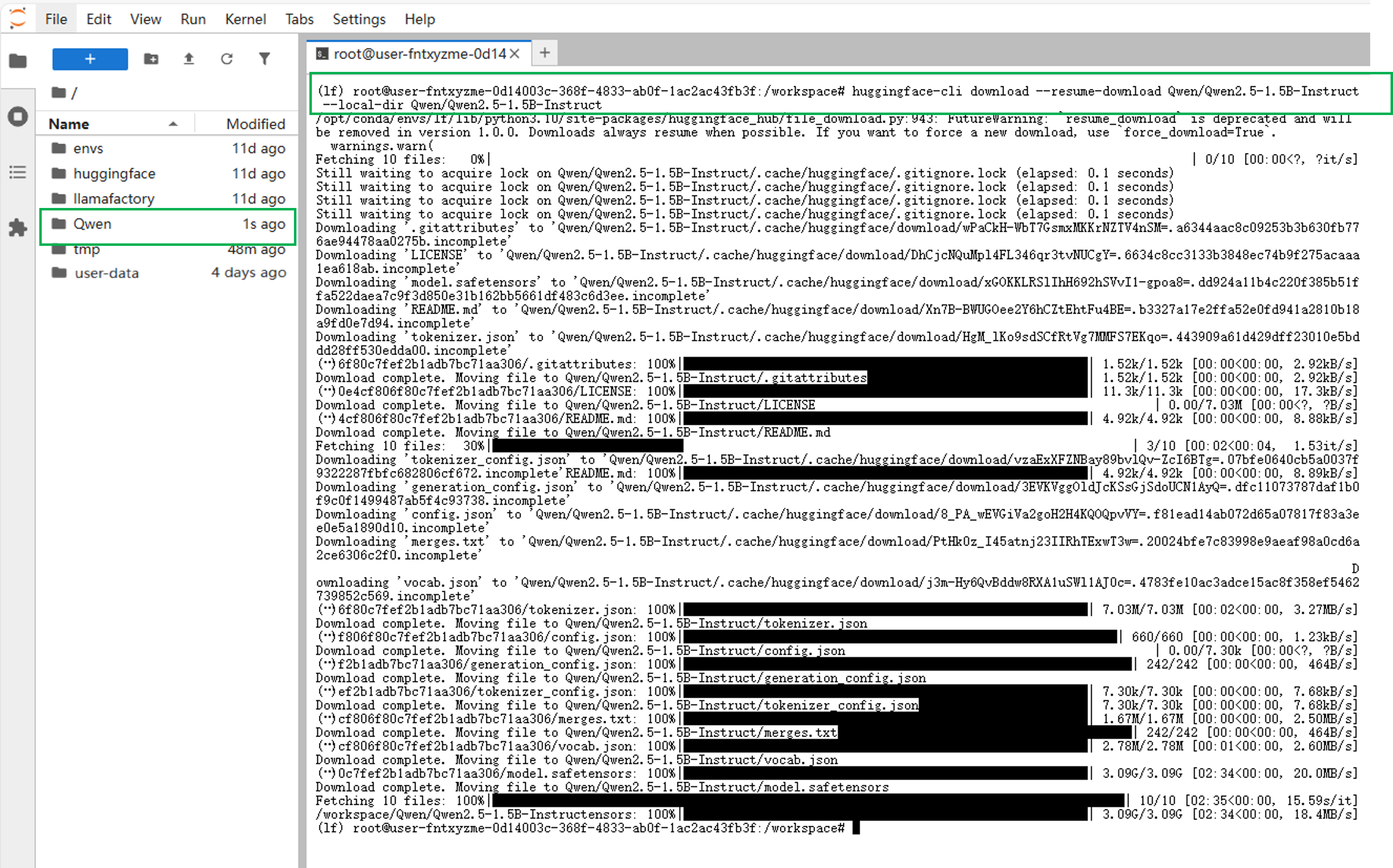

回到实例空间,点击右侧“JupyterLab处理专属数据”进入工作空间下载。 工作空间中的文件目录介绍请参考目录。下载步骤:(以下载模型Qwen2.5-1.5B-Instruct为例)- 在JupyterLab工作空间中,点击启动面板(Launcher)下方的"Terminal"进入终端。

- 输入下载命令,完成下载。

huggingface-cli download --resume-download Qwen/Qwen2.5-1.5B-Instruct --local-dir Qwen/Qwen2.5-1.5B-Instruct 提示

提示上述指令中的

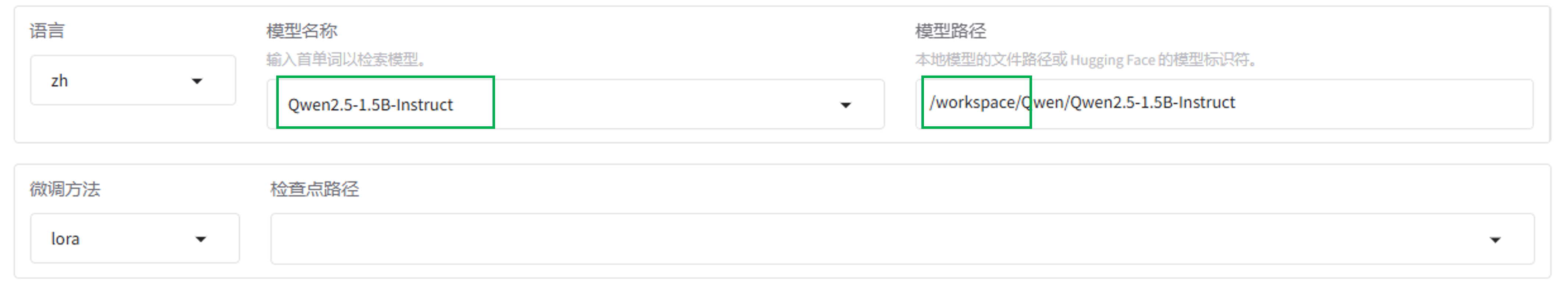

--local-dir Qwen/Qwen2.5-1.5B-Instruct语句,规定将模型下载到/workspace目录下。若不设置该命令,模型默认下载到/workspace/huggingface/hub目录下。- 回到"LLaMA-Factory快速微调模型" Web UI页面,在“模型名称”中找到Qwen2.5-1.5B-Instruct,模型路径要从

/workspace开始写起,写入上一步骤中模型存储的路径。

2.选择数据集

-

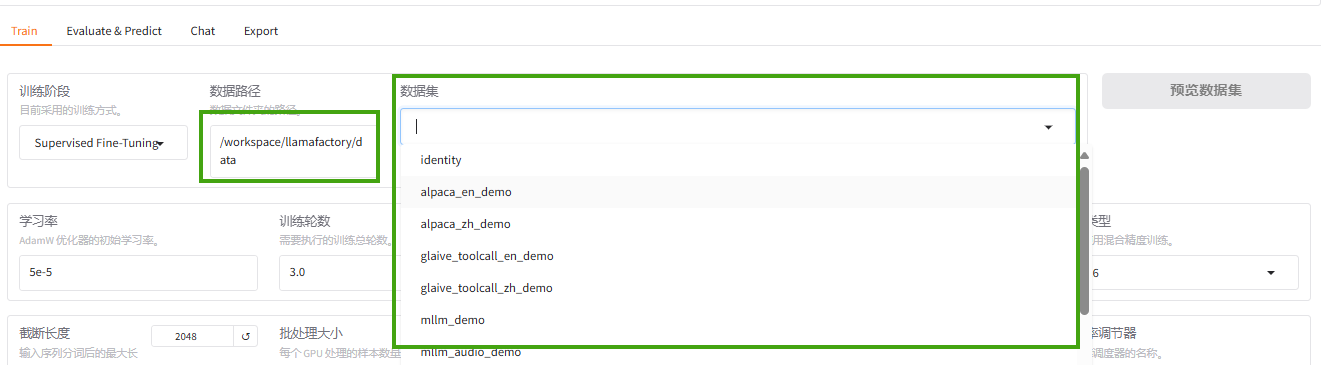

使用已预置的数据集。预置数据集存放在路径

/workspace/llamafactory/data下,您可以直接在“数据集”处选择需要的数据集。

-

使用自定义的数据集。若您需要使用自定义的数据集,可参考数据上传中的JupyterLab上传和SFTP上传下载。

3.开始训练

在训练界面,根据需求设置其他参数(参数设置可参考参数配置),点击“开始”进行训练。

评估和预测

可以通过在评估与预测界面通过指定模型及适配器的路径在指定数据集上进行评估。

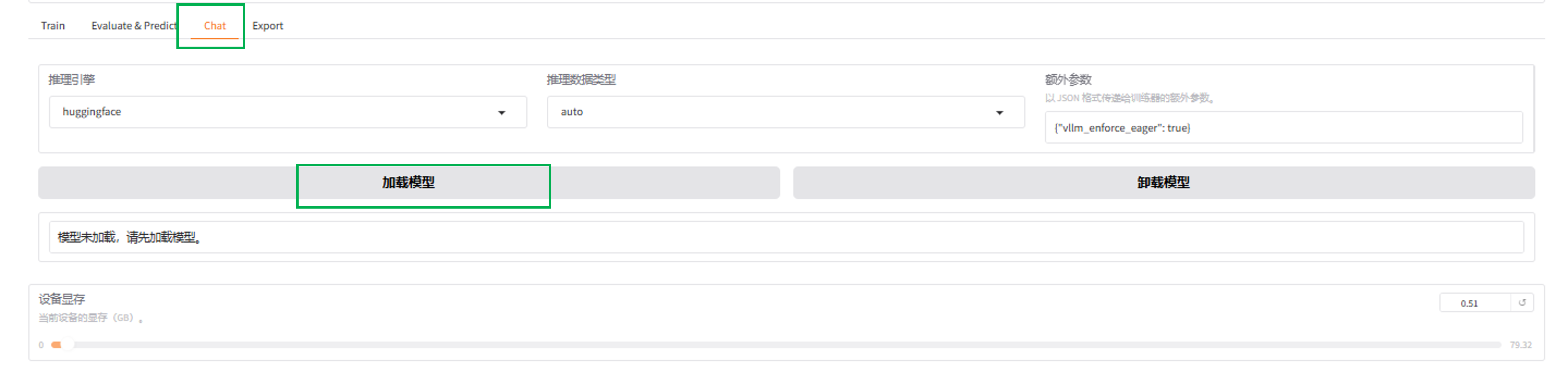

对话

在对话界面,通过指定模型、适配器及推理引擎,输入对话内容与模型进行对话观察效果。

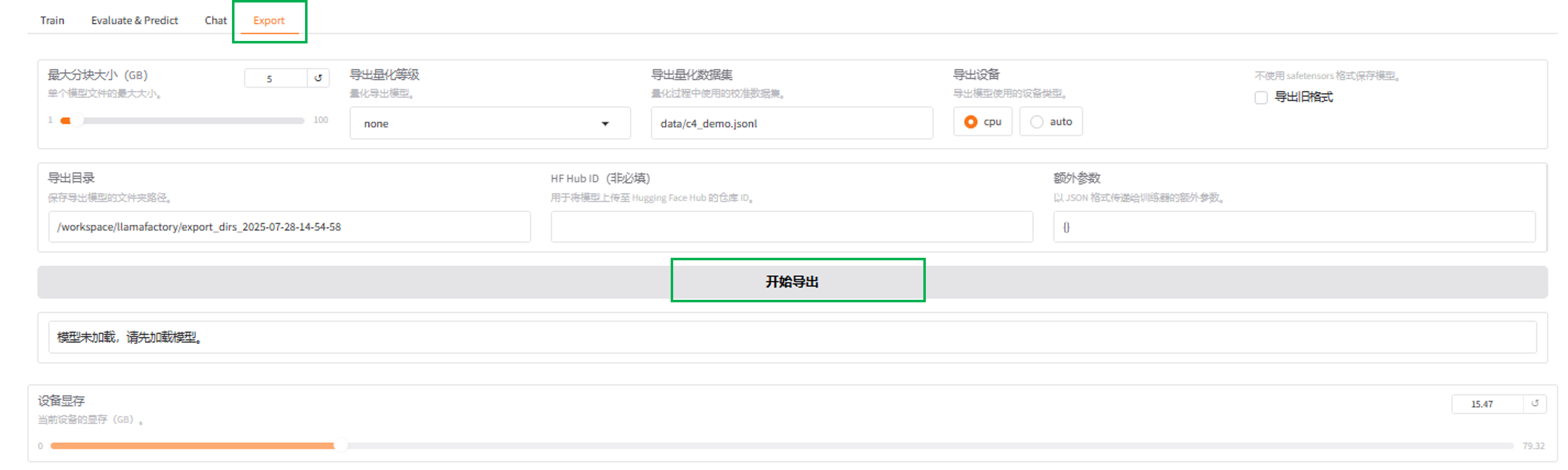

模型导出

在导出界面,您可以通过指定模型、适配器、分块大小、导出量化等级及校准数据集、 导出设备、 导出目录等参数后点击“导出”按钮,导出用户需要的模型。