GPT-OSS不支持LoRA加载进行对话问题排查

问题表现

用户在[微调/模型对话]页面,选择GPT-OSS微调后的LoRA,配置提示词后,单击“开始对话”按钮,配置默认资源,单击“立即对话”后页面无反应,例如下图所示。

问题原因

当前框架(如:vLLM)尚未支持GPT-OSS模型的LoRA推理功能,当尝试调用load_lora_model加载适配器时,系统检测到模型类型不兼容,因而抛出不支持的异常,导致加载失败。

解决办法

-

登录平台后,单击[微调/模型对话]菜单项。在“基础配置”区域,除设置

基础模型、训练数据-公共数据等参数(可与未开启“合并模型”功能时保持一致)外,还需启用“合并模型”功能,例如下图高亮所示。

-

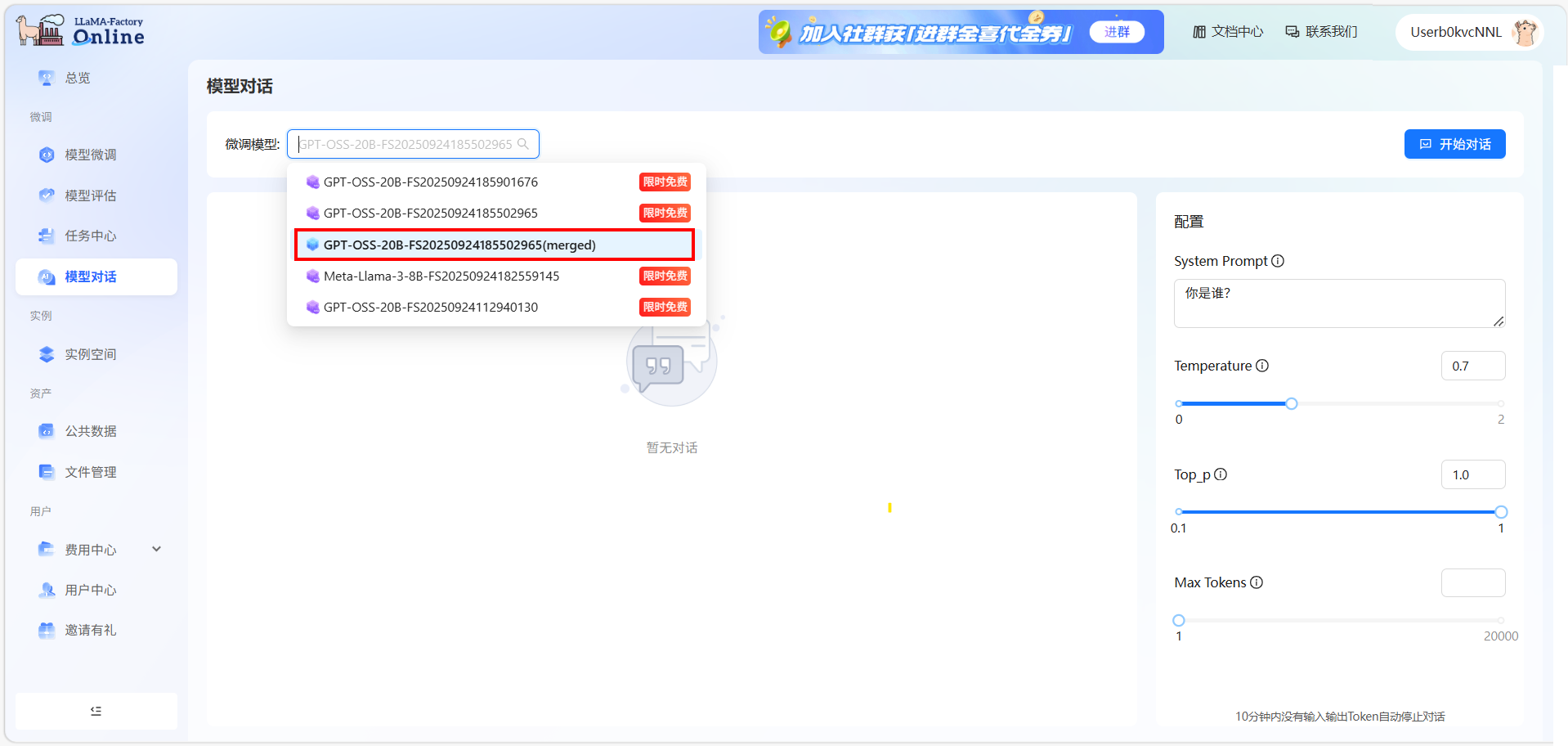

完成参数配置后,启动模型微调。待微调完成后,可在[微调/模型对话]页面选择生成的合并模型,并根据需要配置系统提示词,如下图所示。

-

单击“开始对话”按钮,进入配置资源页面,在资源配置页面,配置所需的GPU资源,例如下图所示。

提示

提示当前,非LoRA模型的对话服务将根据实际GPU资源消耗进行计费,您可根据具体需求选用相应资源。

-

完成资源配置后,单击“立即对话”按钮进入对话创建页面。在此页面中创建对话后,即可开始与模型进行对话,例如下图所示。